allesnurgecloud.com ist ein kuratierter Newsletter mit Inhalten aus der Open-Source, Cloud und IT-Welt.

Für weiteren Content folge mir gerne auf Twitter, Mastodon oder LinkedIn.

Möchtest du den Newsletter wöchentlich per E-Mail erhalten?

Einfach hier abonnieren:

SaaS pricing und Cloud Kosten

Dass David Heineheimer Hansson (DHH) aktuell viel über Cloud-Kosten schimpft, ist dir als regelmäßiger Leser nicht entgangen.

In einem aktuellen Fall greift er nun SaaS Kosten auf. Über den Bericht zu den Q1 earnings von Datadog wurde bekannt, dass eine „Crypto Company“ (vermutlich Coinbase) im Jahr 2021 satte 65 Millionen Dollar an Datadog bezahlt hat. 65 Millionen für eine Observability Lösung? Unglaublich, was man mit Wachstum und Venture-Capital alles bezahlen kann

37signals/Basecamp hat selbst eine 88.000 $ Jahresrechnung an Datadog bezahlt – dies inzwischen aber zum Ende des Monats eingestellt.

Basecamp ist ja selbst auch eine SaaS Company – es gibt zwar ein „pear Seat“ Pricing mit 15 $ / Monat – für größere Firmen aber auch einen „Unlimited Users“ Account für 299 $ / Monat. DHH rechnet selbst damit, dass die SaaS Pricing Bubble platzt:

It’s surprising to me that there isn’t more pressure yet to cut costs at companies paying such princely sums for their SaaS software. But I think it’s coming. It feels like we’re in a service bubble waiting to pop. Someone is going to look at those margins and see an opportunity.

Seinen Artikel hat er zusätzlich auf Linkedin geteilt und dort viel Zuspruch erhalten. Selbst mit 88.000 $ / Jahr könne man viel in Open-Source investieren – nicht auszudenken, was man mit 65 Millionen Dollar alles machen kann.

Neben dem üblichen Stack mit Prometheus/Grafana und Co wurde auch Signoz als Datadog Alternative genannt – ebenfalls Open-Source. Siehe da, ich hatte das in Ausgabe #42 sogar mal vorgestellt.

Die Details zur „65 Millionen Dollar Crypto Company“ hat „The Pragmatic Engineer“ Gergely Orosz zusammengefasst. Coinbase hatte ein fantastisches Jahr 2021 und ging damals an die Börse – man hatte dann wohl keine Zeit, sich die Kosten im Detail anzuschauen. Und vielleicht musste man dies auch gar nicht, bei dem Wachstum:

Following the IPO in summer 2021, nobody at the company cared about infra costs; the only focus was growth. The company racked up huge bills for the likes of AWS, Snowflake, and also Datadog. And so, the $65M bill was for Datadog, for 2021. Coinbase settled the bill in Q1 2022.

In 2022 war Coinbase dann finanziell deutlich mehr unter Druck und hat unter anderem den Monitoring Stack mit einem dedizierten Team auf Grafana, Prometheus und ClickHouse umgebaut. Grafana und Prometheus sollten dir bekannt sein – ClickHouse hatte ich bereits ein paar mal erwähnt. Cloudflare setzt beispielsweise ClickHouse fürs Log Management ein und verarbeitet über 6 Millionen Requests pro Sekunde damit (siehe Ausgabe 73). Und wenn Cloudflare das reicht, dann vermutlich auch dir und mir.

Coinbase ist aber auch heute noch Datadog Kunde: Warum?

Naja, in der Größe möchte man verschiedene Überwachungssysteme kombinieren – denn Downtimes kosten dort richtig Geld:

In 2022, Coinbase had 17 outages, totalling about 12 hours of downtime. The company’s daily average revenue is around $9M/day, based on their 2022 earnings.

Gergely rechnet vor, dass er vermutet, dass mit Datadog die Hälfte der Downtimes vermieden wurden und sich die Datadog Gebühren somit selbst eingespart hätten.

In der weiteren Argumention hilft er zudem bei der Berechnung von Make vs. Buy. Ab 2-5 Millionen Dollar jährlichen Ausgaben könne es sich lohnen, die Software selber zu bauen.

Ob die SAP dies auch so sieht?

It’s not just cloud costs that are out of control

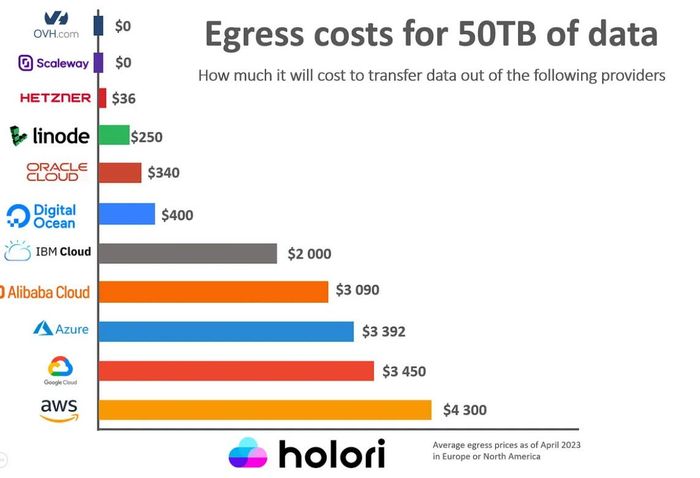

Cloud Kosten Vergleich für Traffic

Wie viel kostet es mich eigentlich, 50 TB aus der Cloud auszuliefern?

Die Zahlen hierfür sind komplett unterschiedlich und reichen von 0 $ bei OVH und Scaleway bis hin zu 4300 $ bei AWS.

Kleiner Unterschied, oder?

Man muss dich die Details anschauen, aber es dürfte dich nicht verwundern, dass AWS, Google und Azure sich Traffic fürstlich bezahlen lassen.

Matthew Prince, CEO von Cloudflare, hatte das ja bereits im Blog Artikel „AWS’s Egregious Egress“ vorgerechnet.

Was fällt noch auf?

Scaleway wird mit 0 $ berechnet – der Traffic ist komplett unlimited, die Brandbreite ist aber nur 1Gbit/s – Upgrades sind allerdings verfügbar.

Bei OVH ist der Traffic ebenfalls kostenlos (es gibt eine „Fair use“ policy“) – die Bandbreite auf sogar nur 500 Mbit/s limitiert.

Und bei den Kollegen von Hetzner sind 20 TB im Monat bei 1Gbit/s Bandbreite inklusive.

Bei Linode hängt der Traffic vom CPU Plan ab – kleine Nodes mit 1 CPU haben nur 1 TB Traffic dabei – größere Nodes mit 32 GB dann 16 TB.

Und bei AWS? Na, da braucht es ein Schaubild, um den Datentransfer und die Implikationen aufs Pricing sauber darzustellen.

100 GB sind inklusive – danach kostet alles – egal ob zwischen AZs (0,01 $ / GB), regionaler Transfer (Egress 0,09 $ / GB) oder Transfer ins Internet. Der ausgehende Transfer ins Internet kostet dann je nach Region zwischen 0,08 $ und 0,12 $ pro GB.

Man kann beim Traffic also massig sparen. Mein Podcast Hoster Podigee ist beispielsweise auf AWS zu Hause – die Podcasts selbst werden allerdings über Infrastruktur bei Hetzner ausgeliefert. Es lohnt sich also, hier genauer hinzuschauen.

Wie kann man ansonsten noch Traffic Kosten sparen?

- Traffic sinnvoll verteilen (siehe oben)

- CDN Einsatz hinterfragen (PDFs kann man auch direkt aus einem Object Storage ausliefern

- CDNs nach Use-Case verwenden (Es gibt auch CDNs mit deutlich günstigerem Traffic als Cloudflare und Co. Unter anderem die Volume PoPs von BunnyCDN)

- Bilder verkleinern und optimiert ausliefern – siehe „Dynamic Image Optimization with imgproxy on STACKIT Cloud Foundry“

- Moderne Komprimierung verwenden (Brotli statt gzip)

Linkedin: Egress Costs im Vergleich

Sponsored

Developer aufgepasst: Werde Teil von anny!

Wir kreieren eine SaaS-Lösung, mit der man alles buchbar machen kann. Mit anny werden Universitäten, Büros, Vermietungen, Dienstleistungen und ganze Festivals verwaltet.

Warum machen wir das? Weil wir daran glauben, dass wir in der heutigen Welt dank Digitalisierung noch viel mehr miteinander teilen können.

Wir suchen Dich als: UX/UI Designer, Senior Frontend Developer oder Full Stack Developer.

Das Besondere in unserem Product Team: Wir haben Sprints den Rücken zugekehrt. Projekte werden bei uns in 6 Wochen Cycle nach der Shape up Methode umgesetzt. So ermöglichen wir jedem Developer eine zweiwöchige Cool Down Phase für selbst gewählte Projekte, bevor es in den neuen Cycle geht. Unser Tech Stack besteht aus Laravel, PHP und Vue.js. Klingt gut? Dann buche dir ohne Umschweife ein Kennenlerngespräch!

Real-time Messaging bei Slack

Slack hat einen ausführlichen Blog-Artikel zur Beschreibung der genutzten Real-time Messaging Infrastruktur veröffentlicht.

Das Herzstück sind sogenannte „Channel-Server“, die in Peak Zeiten bis zu 16 Millionen Slack Channels „stateful“ speichern und ausliefern. Die diversen Channels eines Slack Teams können über mehrere „Channel-Server“ verteilt abgelegt sein. Die „Gateway-Server“ verteilen die User über die „Channel-Server“ und kennen der Identitäten und Zugehörigkeiten.

Zudem sind die Gateway-Server geografisch verteilt und sorgen dafür, dass sich die User weltweit schnell einloggen können. Die „Admin-Server“ sind stateless und in-memory – sie kümmern sich um den Informationsaustausch zwischen den Channel-Servern und der Slack Web-App. Dazu gibt es noch „Presence-Server“, diese wissen, welcher User online ist und welchen Status er hat. All diese Server melden sich an Consul an – dem Service Discovery Tool von HashiCorp.

Jeder Slack Client hält nach Anmeldung eine offene WebSocket Verbindung zu einem regionalen Gateway-Server aufrecht. Diese Verbindungen werden von Envoy Proxy Instanzen verteilt, die sich mit den Gateway-Servern in regionaler Nähe der Clients befinden. Sendet ein Client eine Nachricht in einen Channel, so wird diese per Broadcast an alle Clients verteilt, die aktuell „Online“ sind. Der Nachrichtenfluss einer Nachricht geht somit durch diverse Instanzen bei Slack – der genaue Ablauf ist hier dokumentiert (inkl. Schaubild).

Slack verteilt mit dieser Architektur Nachrichten an „tens of millions of connected clients“ in der ganzen Welt in weniger als 500ms.

Telekom: Urteil gegen Google Ads Nutzung

Die Verbraucherzentrale NRW hat vor dem Landgericht Köln ein interessantes Urteil erwirkt:

Das Landgericht untersagt der Telekom, personenbezogene Daten zu Analyse- und Marketingzwecken in die USA zu übermitteln:

Bei Aufruf der Webseite „www.telekom.de“ übermittelte die Telekom Deutschland GmbH personenbezogene Daten an Google LLC in die USA, um deren Analyse- und Marketingdienste Google Ad Services zu nutzen.

Spannend hierbei: Der Cookie Consent reiche laut der Argumentation nicht aus, da eine weitreichende Aufklärung der Verbraucher:innen nötig sei:

Eine einfache Zustimmung im Cookie-Banner über den Button „Alle akzeptieren“ reiche für eine ausdrückliche Einwilligung für die Drittlandübermittlung in die USA nicht aus. Hierfür sei eine weitreichendere Aufklärung der Verbraucher:innen nötig. Das Urteil ist noch nicht rechtskräftig.

Google Ads würde über Daten wie Browser, IP-Adresse und das verwendete Endgerät Daten über User sammeln und damit „persönliche Profile“ erzeugen, die für die Ausspielung der Werbung genutzt werden würden. Das Landgericht bezieht sich auf die Argumentation der „Schrems II“ Entscheidung und deren maßgebliche Feststellung, dass der Zugriff amerikanischer Behörden auf personenbezogene Daten von EU-Bürgern ein Rechtsverstoß darstelle.

Das Urteil selbst ist noch nicht rechtskräftig und wird sicherlich von der ein oder anderen höheren Instanz nochmals neu bewertet werden.

Telekom darf keine personenbezogenen Daten an Google-Server in die USA übermitteln

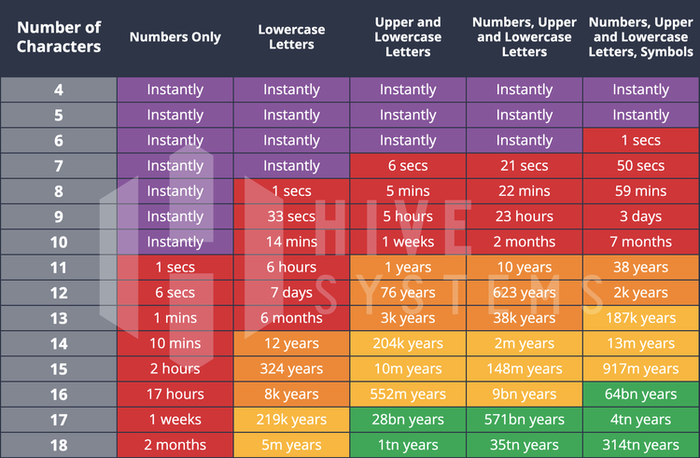

Sicherheit von Passwörtern

Hive Systems hat eine aktuelle Studie zur Cracking Dauer von Passwörtern veröffentlicht.

Wie lange dauert so eine Brute Force Operation auf einer modernen GPU?

Na, ein 8-stelliges Password hat eine RTX 2080 in 6 Sekunden, eine RTX 4090 in einer Sekunde gecracked (aus einem MD5 Hash).

Mit Zahlen, Sonderzeichen und Upper und Lowercase dauert es bei 8 Stellen auf der RTX 2080 dann schon 4 Stunden, auf der RTX 4090 nur 59 Minuten.

Hat man Zugriff auf Cloud Ressourcen, vielleicht weil einem ein AWS Key zugeflogen ist, so dauert das 8-stellige Password mit den Sonderzeichen und Co. auf 12 AWS A100 Maschinen dann nur 12 Minuten.

Eine RTX 2080 arbeitet beispielsweise mit 37 Milliarden Hashes pro Sekunde – 8 x A100 Maschinen dann schon 523 Milliarden Hashes pro Sekunde – also mehr als 10 mal soviel.

Ja, aber wer nutzt noch MD5? Ich denke, leider noch immer viel zu viele.

Wie sieht es mit bcrypt aus?

Schon deutlich besser – das 8-stellige Passwort mit Sonderzeichen und Co. – 17 Jahre.

Alle anderen Daten findest du in einem der Schaubilder, beispielsweise in diesem hier.

Man sollte denn noch immer einen PW Manager verwenden, denn gerade Seiten & Apps, denen man weniger Aufmerksamkeit schenkt, verwenden wohl noch immer MD5 oder andere, unsichere Verfahren:

We reviewed password data breaches from 2007 to present, reported through HaveIBeenPwned, to see what attackers have actually been trying to crack and whether that changed over time. Generally speaking, website logins that people probably care less about, like forums and restaurants, used and continue to use MD5 and SHA-1.

Für dich heißt das: gehe immer vom schlimmsten Fall aus, nutze einen PW Manager und 24 oder 32 Stellen, mit Sonderzeichen und allem – und für jede Page / App einen eigenen Login.

Are Your Passwords in the Green?

TLS Connection Debugging Website

Die hier verlinkte Seite ermöglicht dir, den Connection Aufbau, Handshake, Header und Content Auslieferung exakt der besuchten Page im Browser „live“ anzuschauen und danach zu debuggen – und zwar „Byte für Byte“.

Du siehst den Handshake, die übermittelten Zertifikate, die Verifizierung der Root-CA, die HTTP Header und dann schlussendlich das Dokument selbst – also den. HTML Content.

Den Code dafür findest du auf GitHub.

Schönes Demo Objekt, anhand dessen man TLS, HTTP und Header erklären kann.

See this page fetch itself, byte by byte, over TLS

Humble Bundle: Cloud-Computing Software Bundle

Bei Humble Bundle gibt es ein interessantes Bücher-Bundle zum Thema „Cloud Computing“ mit Fokus auf AWS und Microsoft Azure.

Möchtest du alle 20 Artikel kaufen, so musst du mindestens 22,64 € ausgeben.

Folgende Titel sind enthalten:

- AWS CloudFormation Master Class

- AZ-204 Developing Solutions for Microsoft Azure

- AWS Certified Data Analytics Specialty (2022) Hands-on

- AWS Certified Cloud Practitioner (CLF-C01) [Updated for 2021]

- AZ-900 Microsoft Azure Fundamentals Exam Quick Prep

- AZ-900: Microsoft Azure Fundamentals Certification – 2021

- Amazon Web Services (AWS) Technical Essentials – Ultimate Training Program

- Microsoft Azure Storage – The Complete Guide

- AWS Certified Cloud Practitioner CLF-C01: Exam and Beyond

- AI-900: Microsoft Azure AI Fundamentals Video Course + Ques

- DP-900: Microsoft Azure Data Fundamentals Video Course + Practise Questions

- AWS Certified Solutions Architect Associate (SAA-C03)

- Cloud Computing for Beginners – Database Technologies and Infrastructure as a Service

- Microsoft Azure for ASP.NET Core

- Deploy MEAN Stack App on Azure Cloud with CICD Pipeline

- Deploy any MERN Stack App on Azure Cloud using CICD Pipeline

- Microsoft Azure Functions – Developing Serverless Solutions

- Azure Data Factory for Beginners – Build Data Ingestion

- Learning Microsoft Azure: A Hands-On Training

- Introduction to Cloud Computing

Teilweise haben die Bücher wohl einen älteren Stand, allerdings ist da Bundle im Vergleich zu Einzelpreis dann trotzdem ein gutes Schnäppchen.

The Complete Cloud Computing Software Bundle

Schmunzelecke

„Lost children“ will be taught Kubernetes Networking – twitter @memenetes

💡 Link Tipps aus der Open Source Welt

Formbricks: Open Source Umfragen für deine Produkte

Formbricks ist eine „Open-Source Survey & Experience Management“ Lösung für deine Web-Applikation.

Du kannst damit in deinen Seiten Umfragen zu neuen Features und Designs direkt an User ausspielen. Auch einfache Umfrage können per Link geshared werden.

Eine Vielzahl von Möglichkeiten bietet das Tool selbst, ohne dass du an deinem Applikation-Code etwas ändern musst.

Alle Funktionen findest du hier in der Übersicht.

Zum Ausprobieren gibt es eine kostenlose SaaS/ Cloud Variante – oder einen Pro Account für 49 $ / Monat.

Self-Hosting geht einfach per Docker-Compose – Formbricks benötigt nur noch eine PostgreSQL DB.

https://github.com/formbricks/formbricks

Matano: Open Source Security für AWS

Matano ist ein „Open-Source cloud-native security lake“ (Bingo!) – eine Alternative zu einem SIEM System mit Fokus auf AWS.

Alle unstrukturierten AWS Logs werden in deinem AWS Account strukturiert gesammelt. Zusätzlich gibt es über 50 weitere Sourcen für Events, wie beispielsweise Cloudflare, Duo oder Crowdstrike.

Mit Python Code kannst du dann „Detection-as-Code“ automatisieren – alle Features findest du hier in der Übersicht. Log Daten werden in S3 gespeichert, für die Architektur gibt es dieses Schaubild.

Monetarisiert werden soll das Projekt über die Matano Cloud, für die es bisher aber nur eine Warteliste gibt.