Willkommen zu allesnurgecloud.com – Ausgabe #132!

Vielen Dank für das ganze Feedback zu Sonntag vs. Montag!

Die meisten Rückmeldungen waren „Pro Sonntag“ – deshalb landet diese Ausgabe wieder pünktlich zum zweiten Frühstück in deiner Inbox.

Auf LinkedIn bleibt es erst mal weiterhin der Montag – solltest du also auf LinkedIn abonniert haben und möchtest den Newsletter schon am Sonntag lesen, gerne einfach direkt hier per Mail abonnieren.

Dir gefällt meine Arbeit hier?

Gerne kannst Du meine Arbeit nun auf Patreon supporten, mir ein Bier ausgeben oder mal auf meiner Amazon-Wunschliste vorbeischauen – Danke!

Falls du Interesse hast, im Newsletter oder Podcast Werbung zu buchen, kannst du das auf passionfroot machen.

Podcast mit Zukunftsmotor.org

Im Podcast hatte ich diese Woche ein super spannendes Thema – Pasquale Seliger von Zukunftsmotor.org hat mir ausführlich erklärt, wie man eine Weiterbildungsplattform für Arbeitssuchende baut. Zukunftsmotor hat 2022 die ersten Kurse für „IT-Systemadministrator:innen“ gestartet und die ersten Absolventen erreichten eine Wiedereingliederungsquote von über 80 %. Zukunftsmotor ist komplett bootstrapped und hat selbst bereits über 30 Angestellte.

allesnurgecloud.com ist ein kuratierter Newsletter mit Inhalten aus der Open-Source, Cloud und IT-Welt.

Für weiteren Content folge mir gerne auf Twitter, Mastodon oder LinkedIn.

Möchtest du den Newsletter wöchentlich per E-Mail erhalten?

Einfach hier abonnieren:

Fathom Analytics: AWS Kosten um 100.000 Dollar reduziert

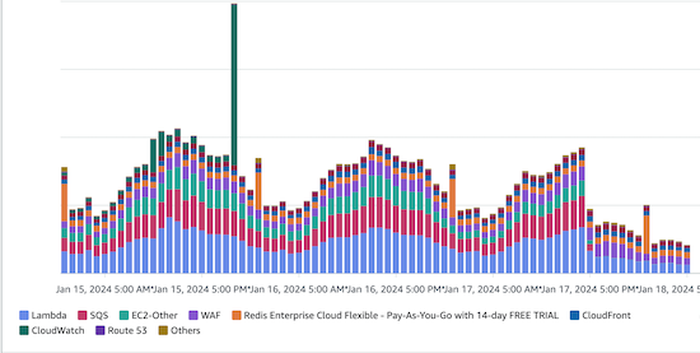

Im Blog der Google Analytics Alternative „Fathom Analytics“ findet sich ein lesenswerter Artikel zum Thema Cloud-Kosten-Reduktion bei AWS.

Durch diverse Maßnahmen konnten die Kollegen um Gründer Jack Ellis die Kosten um 100.000 $ pro Jahr reduzieren.

Das Unternehmen selbst ist „bootstrapped“ und es ist etwas passiert, was für SaaS Anbieter typisch ist. Die Kosten sind mit dem Umsatz mit gewachsen – und das ist natürlich nicht nachhaltig & wirtschaftlich.

In der Optimierung konzentrierte man sich auf die Ingress Endpoints, die Milliarden von Requests pro Monat verarbeiten. Der Weg des Traffics sieht wie folgt aus:

CDN (not CloudFront) -> WAF -> ALB -> Lambda -> SQS -> Lambda -> [PHP script which utilizes Redis and SingleStore] -> Done -> Add to CloudWatch logs

Cloudwatch

1000 $ pro Monat entstanden duch Job Queue Einträge, die ohnehin in Sentry gespeichert wurden. Die waren also redundant und können einfach weg. In dem Fall kamen die Logs über eine Deployment-Option von „Laravel Vapor“ automatisch mit – normal tun die nicht so weh, aber in der Größenordnung halt schon.

NAT Gateway

Sicherlich eine der Cashcows von AWS – das liebe NAT Gateway – darüber hatten wir es hier schon paar mal. Bisher liefen alle ausgehenden Connections über das NAT Gateway – die Connection zum managed Redis Cluster läuft jetzt über ein VPC Peering, die zur SingleStore Database über ein AWS PrivateLink – Kostenersparnis: $17.162 pro Jahr.

Als Alternative hätte Jack sich auch das fck-nat Projekt anschauen können, das mittlerweile auch Support für HA Instanzen bietet.

S3 Object Storage

Im S3 war historisch bedingt die Archivierung aktiviert – diese wurde deaktiviert und die alten Versionen gelöscht – Kostenersparnis: $5.774 pro Jahr – das ist ein schöner Business-Trip, mit ein paar Klicks.

Route53 (DNS)

Ja, auch der DNS Dienst wird bei AWS nach Anzahl Queries abgerechnet. Ist halt schön integriert, daher nutzen das viele. Ist die DNS TTL hier zu kurz, bzw. nicht sinnvoll hoch eingestellt, so zahlt man halt einfach ein Vielfaches von dem, das nötig ist. In Summe sind das bei Fathom Analytics dann $2.547 pro Jahr, die gespart werden.

Klar, Cloudflare und Bunny rechnen jetzt nicht direkt nach Queries ab, da hätte man auch optimieren können, aber ist halt nicht so direkt in AWS integriert.

Lambda & SQS

Beim Thema Lambda & SQS konnte das Team $20.862 Kostenersparnis erreichen. Einmal wurden die Lambda Requests pro Pageview von zwei auf einen reduziert – das macht natürlich ne Menge aus. SQS wird nicht mehr verwendet, um die Daten der DB zu syncen, sondern das wurde architektonisch so angepasst, dass man auf SQS verzichten kann.

WAF

Hier wird man bald ganz auf den WAF Service von AWS verzichten und auf den Service des CDN Providers umziehen. Jack nennt hier cdn77 und bunny als Alternativen, gibt aber an, dass sie hier eher nicht auf Bunny setzen wollen. Schaut man sich den Traffic der Fathom Analytics includes an, so werden diese aktuell von cdn77 geproxied – bei CDN77 gibt es ein Produkt namens SmartWAF und den Rest kann man sich dann wohl zusammenreimen. Kostenersparnis hier: $12.201 / Jahr.

CloudFront

Und hier konnten immerhin $4.800 pro Jahr eingespart werden, da die Konfiguration der „Popular Objects“ optimiert wurde.

Fazit

In Summe konnte man $94.885 pro Jahr einsparen – dazu kommen die 3 % AWS Support, die verbrauchsabhängig ebenfalls gespart werden – macht $97.731,55. Und mit allen Steuern wären es dann knapp $110.000, die Fathom Analytics nun im Jahr einspart.

Auf Twitter hatte ich Jack gefragt, wie lange er für die Optimierungen benötigt hat – „under a Week“ – das Thema FinOps lohnt sich also sehr schnell.

Reducing our AWS bill by $100,000

Layoffs bei Personio, SAP, eBay, Microsoft & SalesForce

Die Layoff Runde zieht sich leider auch in dieser Woche fort.

Beim Münchner HR Start-up Personio müssen 101 Mitarbeitende das Unternehmen verlassen. Wie Businessinsider berichtet, sind vor allem die Produkt- und Technologie-Abteilung von den Kündigungen betroffen. Insgesamt arbeiten aktuell um die 2100 Angestellte.

Vor kurzem hatte Microsoft Apple als wertvollstes Unternehmen der Welt überholt – nun entlässt man bei Activision Blizzard und bei Xbox mit 1900 Angestellten ungefähr 8 % der Microsoft Gaming Sparte (Quelle: The Verge). Die Gaming-Sparte hatte zuvor ungefähr 22.000 Mitarbeitende – Blizzard President Mike Ybarra verlässt Blizzard ebenfalls in diesem Zuge.

Der Online-Marktplatz eBay entlässt 1000 Vollzeit-Angestellte – laut CNBC sind das ungefähr 9 % der Angestellten. Jamie Iannone, CEO von eBay, klärt in einer öffentlichen Mittelung an das Team darüber auf, dass eBays Personal-Wachstum schneller war, als die Umsätze – daher müsse man die Firma neu aufstellen.

Und auch der CRM-Anbieter Salesforce trennt sich von 700 Mitarbeitenden, 1 % der aktuellen Belegschaft. Parallel dazu habe man allerdings 1000 offene Stellen zu besetzen.

Die SAP kommuniziert das Thema etwas anders – über eine Umstrukturierung möchte man die Jobs von 8000 Angestellten verändern. Parallel dazu erhalten die Mitarbeitenden Abfindungsangebote, falls die das Unternehmen verlassen möchten. Bis zum Jahresende soll sich die Anzahl der Vollzeit-Angestellten daher nicht ändern.

Laut dem Tracker Layoffs.io wurden im Jahr 2024 im Techbereich schon 24.585 entlassen.

Sponsored

Hier könnte Deine Werbung stehen

Du möchtest Deine Firma, angebotene Dienstleistungen & Services oder Dein SaaS Produkt hier im Newsletter vorstellen?

Du suchst neue Mitarbeiter und möchtest diese direkt erreichen?

Erreiche um die 1000 Cloud und Open-Source Enthusiasten direkt per E-Mail, LinkedIn oder im RSS-Feed.

Bei Interesse antworte mir einfach auf diesen Newsletter oder buche direkt einen Slot bei Passionfroot.

Campfire Chat ist erstes Basecamp ONCE Produkt

Der SaaS Anbieter 37signals mit seinen Produkten Basecamp & Hey ist hier ja öfters Thema – zuletzt wegen der Cloud Exit Geschichte, die ich auch mit Spannung verfolgt habe.

Einmal kurz angerissen hatte ich, dass 37signals in Zukunft eine Alternative zu den gängigen SaaS Modellen anbieten möchte. Mit ONCE möchte man „back to the roots“ und Produkte mit einer einmaligen Lizenz anbieten. Seit der Ankündigung wurde spekuliert, was denn nun das erste ONCE Produkt werden wird.

Nun ist klar – es wird die Group Chat Applikation Campfire – eine Alternative zu Slack und Teams, die 37signals schon früher angeboten hatte. Für einmalige 299 $ bekommen Kunden ein Chat Produkt und alle Updates der 1.x Version von Campfire. Campfire kann dann für die 299$ auf einer Domain installiert und betrieben werden – 37signals inkludiert einen „Basic Support“ via E-Mail.

Campfire zielt darauf ab, die primäre Chat Lösung zu werden, falls die Slack oder Teams Kosten explodiert sind. Campfire kann aber auch Backup Chat werden oder auf großen Konferenzen und Events als instant-Chat via QR-Code genutzt werden, da Campfire eine PWA App ist und direkt mit Notifications über den Browser im Handy lauffähig ist.

Ein 8-minütiges Walkthrough Video findest du hier auf YouTube. Zudem gibt es eine Installationsanleitung, die ebenfalls in 8 Minuten erklärt, wie Campfire mit einem One-Liner auf einem virtuellen Cloud-Server installiert werden kann. Campfire kommt als Docker Image. Laut den System Requirements kann man mit 2 GB RAM und einer CPU bereits 250 „Concurrent User“ betreiben. 10.000 parallele User sind dann mit dem einzelnen Docker Image auf einem Host mit 64 GB RAM und 32 CPUs möglich.

Laut DHH habe man auf einem einzelnen Server sogar mit 30.000 Concurrent Usern auf einer AWS Maschinen getestet – als Datenbank verwendet Campfire übrigens eine SQLite DB.

Der Campfire Rollout erfolgt aktuell über eine E-Mail Warteliste – der Download ist also noch nicht „public“ möglich. Ich habe einen Link, kann den aber hier nicht sharen – falls dich das Produkt interessiert, schreib mir gerne und schicke dir den Link. Kann aber gut sein, dass nur ein User diesen dann auch nutzen kann.

DDoS Attacke bei 37Signals

Die Twitter Bubble hat sich diese Woche etwas über den Cloud-Exit von 37Signals echauffiert, da man Cloud, On-Premise und DDoS verwechselt hat.

Was war passiert?

Die Angebote von 37signals wurden aus Indonesien über eine DDoS Attacke angegriffen. Im Peak schossen 80.000 Requests pro Sekunde das System dahinter ab. Ein paar Zahlen dazu gibt es im Cloudflare Screenshot bei @DHH. Scheinbar reichte hier die DDoS Protection des Housing Anbieters Deft.com nicht aus und man migrierte die Internet-Services kurzfristig zu Cloudflare. Hier war das Problem dann gewohnt und schnell beseitigt.

Aktuell laufen die Services auch noch da, früher wurden die Dienste auch schon über Cloudflare geproxied – warum man das mit dem Cloud-Exit (Vermutung) deaktiviert hat, ist mir schleierhaft – denn eine DDoS Protection macht ja immer Sinn, egal ob die Services in der Cloud, bei einem Housing-Anbieter oder auf dem Raspberry PI zu Hause laufen, direkt verbunden macht das meist keinen Sinn.

Falls man zwingend EU-Alternativen zu Cloudflare benötigt, so kann ich hier nochmals auf das hervorragende Preis-Leistungs-Verhältnis von BunnyCDN hinweisen.

Sicherheitslücken in sämtlichen GitLab Versionen

Über das Release von GitLab 16.8 hatte ich in der letzten Woche schon berichtet.

Nach der kritischen „Account Takeover via Password Reset“ Schwachstelle (CVE-2023-7028) gibt es nun kurze Zeit später eine weitere, kritische Lücke in den GitLab Versionen 16.0 – 16.5.7, 16.6.0 – 16.6.5, 16.7.0 – 16.7.4 und in der aktuellen Version 16.8. Die „Arbitrary file write while creating workspace“ Lücke ist ebenfalls als Critical eingestuft (CVE-2024-0402) und GitLab empfiehlt dringend, seine eingesetzte Version zu aktualisieren.

Laut dem verlinkten Artikel bei Golem vom 25.01.2024 waren zu dem Zeitpunkt noch über 5400 öffentliche GitLab Instanzen anfällig gegenüber dem vorherigen CVE-2023-7028 – in Deutschland stehen hiervon alleine mindestens 730 betroffene Instanzen.

Die vorherige Lücke (CVE-2023-7028) halte ich für deutlich kritischer als die aktuelle – grundsätzlich kann man sich natürlich immer mit 2FA zusätzlich absichern – das ist natürlich ohnehin zu empfehlen. GitLab platziert einen entsprechenden Hinweis auf die Lücke direkt nach dem Login – warum man es dann innerhalb von 7-10 Tagen nicht schafft, eine öffentliche Instanz zu patchen, verstehe ich nicht. Das ist doch super zu automatisieren und je öfter man dies automatisiert macht, desto geringer ist die Änderungsrate und somit das Risiko bei einem Update.

Golem.de: Nutzerkonten Tausender Gitlab-Systeme lassen sich kapern

Sys:All: Konfigurationsfehler in Google Kubernetes Engine

Über eine Default-Rollenzuweisung in Google Kubernetes Engine Clustern können Angreifer auf Daten und Secrets in GKE Clustern zugreifen.

Die Sicherheitsforscher von Orca hatten das Problem entdeckt und in einem schnellen Scan mindestens 250.000 betroffene Cluster gefunden – man schätzt aber, dass potenziell über 1 Million Cluster betroffen sein könnten.

Das Sys:All getaufte Sicherheitsproblem beruht auf einem Missverständnis in der Rollenzuweisung der Gruppe „system:authenticated“ – viele Administratoren würden davon ausgehen, dass mit Zuweisung nur Accounts in der eigenen Organisation Zugriff gewährt werde – allerdings inkludiert die Gruppe sämtliche User mit einem Google Account, auch außerhalb der eigenen Organisation.

Google empfiehlt daher über das Security-Bulletin GCP-2024-003 ein Upgrade auf die GKE Version 1.28, die diese Gruppe im Default einschränkt. Google schreibt zum Problem selbst Folgendes:

Es wurden mehrere Cluster gefunden, in denen Nutzer der Gruppe system:authenticated Kubernetes-Berechtigungen erteilt haben. Dazu gehören alle Nutzer mit einem Google-Konto. Diese Arten von Bindungen werden nicht empfohlen, da sie gegen das Prinzip der geringsten Berechtigung verstoßen und sehr großen Nutzergruppen Zugriff gewähren

Google Cloud und GKE Nutzer werden/wurden außerdem über die Problematik via E-Mail informiert.

Die Forscher von Orca haben bei ihrem Scan über 1300 Systeme entdeckt, die in dieser Rolle ebenfalls Cluster-Admin Rechte beinhaltete – darüber wäre dann ein Zugriff auf sämtliche Secrets und Daten in einem Cluster möglich.

OpenSearch Leadership Committee mit externer Governance

Amazon bzw. AWS stand in der Vergangenheit in der Kritik, da OpenSearch zwar ein Open-Source-Projekt sei, aber komplett von AWS geführt werde. Eine Art Pseudo Open-Source-Projekt also, damit das Ganze zur Marketingstory gegenüber Elasticsearch passt.

Nun hat man bekannt gegeben, dass das OpenSearch Leadershop Committee, das die Governance des Projektes beaufsichtigen soll, nun auch mit AWS externen Menschen besetzt wurde. Neben diversen Engineers von AWS selbst sind Maintainer, Entwickler und Developer Advocates von Oracle, Aiven, Logz.io, Develomentor und Aryn.ai Teil des Governance-Teams.

Das Projekt habe mittlerweile über 320 Millionen Downloads zu verzeichnen, über 70 beteiligte Partner und zum Ende 2023 über 227 Maintainer von unterschiedlichen Firmen.

Nutzt du selbst auch OpenSearch? Noch Elastic oder was ganz anderes?

OpenSearch Expands Leadership Beyond AWS

Ceph Storage-Cluster mit über 1 TiB/s bei Random Reads

Ceph ist das Standard Storage Produkt in einem OpenStack Cluster. Im verlinkten Blog-Artikel im Ceph Blog beschreibt Ceph-Spezialist Mark Nelson, wie er mit mehreren Iterationen Testing und Tuning in einem Cluster eine Random Read Rate von über 1 TiB/s erreicht hat. Ein Kunde seiner Firma Clyso wollte seine Daten auf ein neues System migrieren.

Man hatte hierfür entsprechende HW mit gewissen Parametern konfiguriert (Beispielsweise wollte der Kunde nicht mehr als 1000-1500 Watt zusätzlichen Stromverbrauch pro Rack) – Clyso hat die Konfiguration zusammen mit Partner optimiert und sich dann am Ende für 1 HE Server von Dell (Dell PowerEdge R6615) entschieden.

Und so wurden 68 Systeme mit folgender Konfiguration bestellt:

- CPU: 1 x AMD EPYC 9454P 48C/96T

- Memory: 192GiB DDR5

- Network: 2 x 100GbE Mellanox ConnectX-6

- NVMe: 10 x Dell 15.36TB Enterprise NVMe Read Intensive AG

- OS Version: Ubuntu 20.04.6 (Focal)

- Ceph Version: Quincy v17.2.7 (Upstream Deb Packages)

Beim Testing wurden 3 Probleme gefixed:

- die CPUs liefen im Bios gedrosselt und nicht im „Maximum Performance Mode“

- Der Kernel hat Default IOMMU (Input Output Memory Management Unit) aktiviert – dies führte zu einer deutlichen I/O Drosselung

- die verwendeten Upstream Packages in debian waren mit falschen Flags kompiliert

Am Ende des Testings waren die beiden 2 x 100GbE Mellanox der limitierende Faktor der Benchmarks, da diese komplett saturiert werden konnten. In einem zukünftigen Test würde Mark den gleichen Cluster gerne mal mit 200GbE+ Karten testen.

Bisher gibt es keine weiteren öffentlichen Cluster, die 1 TiB/s erreicht haben – Mark ruft dazu auf, sich zu melden, falls man mehr erreicht hat.

Bei heise.de gibt es eine Zusammenfassung des Benchmarks inklusive Testergebnissen.

Schmunzelecke

Falls du ein neues Quad, E-Bike oder einen Buggy suchst – schau unbedingt auf www.arngren.net vorbei – aber sag nicht, ich hätte dich nicht gewarnt.

Kleine Hommage an den E-Commerce von früher – aber irgendwie doch ernst gemeint?

💡 Link Tipps aus der Open Source Welt

Zed – „most advanced code editor“ nun Open Source

Der „Most Advanced Code Editor“ Zed ist nun Open Source verfügbar.

Zed wurde von einigen ehemaligen Atom Entwicklern ins Leben gerufen und verspricht nicht nur mehr Performance, sondern auch eine höhere Flexibilität als Alternativen wie Sublime Text und VS Code. Zed unterstützt außerdem GitHub Copilot und GPT-4.

Besonders an Zed ist zudem, dass man zusammen Code mit einem Team-Kollegen entwickeln kann – das funktioniert über die hier beschriebenen Channels. Zed hat zusätzlich ein integriertes Collaboration und Screensharing Feature.

Zed gibt es bisher nur für macOS (Download hier).

https://github.com/zed-industries/zed

Korb – Daten zwischen K8s PVCs verschieben

Korb ist ein Tool, mit dem du Daten zwischen Kubernetes PVC Storage Klassen verschieben kannst.

Du kannst Korb außerdem für Backup der Daten in ein .tar Archiv nutzen.

Korb kannst du einfach via brew install korb installieren und verwenden.

https://github.com/BeryJu/korb

❓ Feedback & Newsletter Abo

Vielen Dank, dass du es bis hierhin geschafft hast!

Kommentiere gerne oder schicke mir Inhalte, die du passend findest.

Falls dir die Inhalte gefallen haben, kannst du mir gerne auf Twitter folgen.

Gerne kannst du mir ein Bier ausgeben oder mal auf meiner Wunschliste vorbeischauen – Danke!

Möchtest du den Newsletter wöchentlich per E-Mail erhalten?

Einfach hier abonnieren: