Willkommen zu allesnurgecloud.com – Ausgabe #210

Tja, nach AWS ist nun Azure ausgefallen und wie stehen jetzt wohl die Wetten auf einen GCP Ausfall nächste Woche?

Ansonsten gab es auch Earnings der Hyperscaler in dieser Woche – hat es nicht mehr in die aktuelle Ausgabe geschafft – schau ich mir dann aber für nächste Woche an. Als Preview kannst du auch die aktuelle Doppelgänger Folge 506 anhören, da werden die Earnings alle besprochen.

Ansonsten hat Signal CEO Meredith Whittaker ironischerweise auf ihrem dezentral organisierten Mastodon Account erklärt, warum Signal auf AWS angewiesen sei. Bei Heise gibt es einen kleinen Artikel dazu, der dann wiederum erklärt, dass der Mittbewerber Threema lediglich mit 2 Datacentern und eigenen Servern in der Schweiz auskommt. Tja – dazu passt dann wieder der Heise Artikel von Martin Gerhard Loschwitz, den ich in der zweiten News verarbeitet habe.

Happy Bootstrapping Podcast

In der aktuellen Folge 145 spreche ich mit Nicolai Klemke vom AI Music Video SaaS „Neural Frames“. Nicolai und sein 6-köpfiges Team machen 7-stellige Umsätze mit Neural Frames – ein fünfstelliger Betrag geht im Monat aber für GPU Kosten drauf. Einer der Dienstleister hierfür ist übrigens fal.ai aus dem letzten Newsletter – da schließt sich dann der Kreis. Cooles Startup und crazy Videos, mit denen Leute dann wiederum teilweise ihren Lebensunterhalt verdienen – hör gerne mal in Folge 145 rein (Spotify / Apple).

Wenn dir die Podcast Folgen zu lang sind, kannst du gerne auch den Newsletter dazu abonnieren – erscheint jeden Montag (in der Regel).

Support the Newsletter

Übrigens kannst Du meine Arbeit nun auf Patreon supporten, mir ein Bier ausgeben oder mal auf meiner Amazon-Wunschliste vorbeischauen – Danke! Falls du Interesse hast, im Newsletter oder Podcast Werbung zu buchen, kannst du das auf passionfroot machen oder mir einfach ne E-Mail als Antwort auf den NL schicken.

allesnurgecloud.com ist ein kuratierter Newsletter mit Inhalten aus der Open-Source, Cloud und IT-Welt.

Für weiteren Content folge mir gerne auf Twitter, Mastodon oder LinkedIn.

Möchtest du den Newsletter wöchentlich per E-Mail erhalten?

Einfach hier abonnieren:

Massive Azure-Störung legt Microsoft-Dienste weltweit lahm

Nach dem AWS Ausfall vom 20. Oktober war jetzt 9 Tage später Azure dran. Am 29. Oktober 2025 kam es zu einem schwerwiegenden Ausfall bei Microsofts Cloud-Diensten. Dr. Christopher Kunz berichtet auf heise online, dass Microsoft 365, Azure, Outlook und sogar Gaming-Dienste wie Xbox und Minecraft betroffen waren. Der Konzern bestätigte Probleme mit seinem weltweiten CDN „Front Door“ und machte zunächst DNS-Probleme für die Ausfälle verantwortlich. Schon wieder DNS? 😉

Die Störung begann gegen 15:45 UTC und betraf Nutzer weltweit – von den USA über Europa bis Deutschland. Auf Portalen wie „Allestörungen“ zeigten sich deutlich erhöhte Meldungen. Besonders brisant: In den Niederlanden fielen sogar Zugverbindungen aus, da das Bahnsystem auf Azure basiert. Dies fiel ausgerechnet mit dem Wahltag zusammen, sodass manche Wähler nicht rechtzeitig nach Hause kamen.

Erst 33 Minuten nach Störungsbeginn wurde die Statusseite aktualisiert – ein Punkt, der auf Hacker News heftig kritisiert wurde. Microsoft identifizierte eine Fehlkonfiguration in Azure Front Door als Ursache und begann mit einem Rollback auf die letzte funktionierende Konfiguration.

Der Konzern empfahl zeitweise, das CDN zu umgehen und Inhalte direkt von den Origin-Servern auszuliefern – ein riskanter Tipp, da diese schnell überlastet werden können. Gegen 19 Uhr waren die meisten Dienste wiederhergestellt, die vollständige Behebung dauerte jedoch mehrere Stunden.

In der Hacker News Diskussion zum Ausfall mit über 750 Kommentaren hagelte es deutliche Kritik:

Ein User wiess darauf hin, dass die Statusseite von Microsoft notorisch unzuverlässig sei: „That status page is never red. Absolutely useless.“ Andere beschwerten sich, dass die Seite zunächst auf das Azure Portal verwies – welches selbst ausgefallen war.

Besonders ärgerlich für Betroffene: Ein Kommentator berichtete, in einem Supermarkt gestrandet zu sein, weil die Kassen nicht funktionierten. Ein anderer konnte seinen Alaska Airlines Flug nicht einchecken.

Strukturelle Probleme? Die Diskussion offenbarte grundsätzliche Probleme mit Azure. Nutzer neya kritisierte: „Azure has always been a complete joke. It’s extremely developer unfriendly, buggy and overpriced.“

cyptus berichtete, dass Azure Front Door in Europa regelmäßig ausfalle, oft ohne jede Meldung auf der Statusseite: „In 50%+ the cases they just don’t report it anywhere, even if it’s for 2h+.“

Parallelen zur AWS-Störung

Nur eine Woche zuvor hatte es eine ähnliche 12-stündige AWS-Störung gegeben. Mehrere Kommentatoren spekulierten, ob Microsoft versucht habe, ähnliche Probleme präventiv zu beheben und dabei erst das eigentliche Problem ausgelöst habe. Ein Nutzer zitierte Master Oogway: „One often meets his destiny on the path he takes to avoid it.“

Die Cloud-Abhängigkeits-Debatte

Die Störung befeuerte erneut die Diskussion über Cloud-Abhängigkeit. foresterre kommentierte, dass in den Niederlanden fast der gesamte öffentliche Nahverkehr ausgefallen sei – kritische Infrastruktur sollte nicht von einem einzelnen US-Cloud-Provider abhängen.

Ein Nutzer fasste das Dilemma zusammen: „Multi-cloud is really hard to get right at scale, and honestly not worth the effort for the majority of companies.“ Gleichzeitig zeige die Häufung von Ausfällen bei den großen Anbietern, dass echte Redundanz kaum mehr existiere.

Die Azure-Störung zeigt einmal mehr die Fragilität moderner Cloud-Infrastruktur. Während Microsoft an seiner Kommunikation und Transparenz arbeiten muss, stellt sich grundsätzlich die Frage, ob kritische Infrastruktur überhaupt in der Public Cloud gehostet werden sollte oder ob es keine Regulierung für eine ordentliche Verteilung geben sollte.

Störung bei Microsofts Cloud: Ausfälle bei Outlook und Co. gemeldet

Verschläft Europa die Cloud-Souveränität?

Nach dem massiven AWS-Ausfall letzte Woche überschlagen sich Berater mit Empfehlungen für Multi-Cloud-Strategien. Doch Martin Loschwitz warnt in seinem heise-Kommentar: Das greift viel zu kurz.

Das Kernproblem: US-Abhängigkeit

Viele Consultants preisen nun Azure oder Google Cloud als Alternative zu AWS an. Loschwitz nennt dies „aus europäischer Sicht nachgerade grotesk“ – denn alle drei Hyperscaler unterliegen US-Jurisdiktion und können jederzeit zum politischen Spielball werden.

Sein Szenario: Wenn Krankenhäuser, Energieversorger oder Behörden von US-Cloud-Diensten abhängen, die plötzlich aus politischen Gründen gesperrt werden, droht Katastrophe. „Sie brauchen einen Krankenwagen? Donald Trump sagt nein.“

Alibi-Debatten statt Lösungen

Konstrukte wie „Datentreuhänderschaft“ seien Augenwischerei. Ein Microsoft-Vertreter musste vor dem französischen Parlament zugeben, gegen US-Behörden machtlos zu sein. Besonders absurd: Die Bundeswehr baut ihre Cloud mit Google-Unterstützung – was soll da schon schiefgehen? 😉

Loschwitz plädiert jetzt nicht für reine On-Premises-Lösungen:

„Schließlich fehlt mindestens eine ganze Generation von Systemadministratoren. Denn die Industrie hat in den vergangenen 20 Jahren lieber vorrangig Entwickler ausgebildet, um das nächste europäische Einhorn zu schaffen. Und in völliger Ignoranz der Tatsache, dass dieses Einhorn dann auch jemand betreiben muss.“

Europa müsse aber endlich eigene souveräne Cloud-Alternativen schaffen: „Der perfekte Zeitpunkt wäre vor 20 Jahren gewesen. Der nächstbessere ist genau jetzt.“

Witzigerweise kam der Artikel noch vor der Azure Störung raus. Und irgendwie hat Microsoft die Argumentation damit nochmals unterstrichen, würde ich sagen. Hab ich jetzt die perfekte Lösung? Sicherlich nicht, wer hat sie schon.

Die ganzen Störungen haben aber sicherlich gezeigt, dass wir viel zu naiv mit dem Thema Cloud und „die kümmern sich schon“ umgegangen sind.

Am Ende hilft es dir ja nichts, wenn deine DB in Azure oder AWS Multi-Region fähig betrieben wird – auch hier muss alles Multi Region fähig sein – wenn schon der Login nicht geht, die Bezahlung für dein Bahn Ticket oder die gespiegelten Daten einfach veraltet sind – ist alles egal, das Ergebnis ist das Gleiche und das Chaos ist perfekt.

Kommentar zum Totalausfall bei AWS: Nichts gelernt in den letzten 30 Jahren

Anzeige

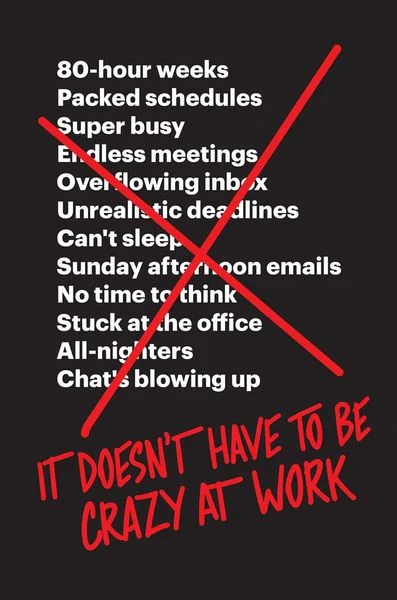

Buchtipp: „It Doesn’t Have to Be Crazy at Work“

Da ich aktuell keine Werbeslots habe und euch nicht immer mit Werbung für meine eigene Firma beglücken möchte – gibt es hier in Zukunft auch immer mal wieder ein paar Buchtipps von mir. Gerne kannst du mir auch schreiben, welche Bücher dir gefallen und vor allem warum.

Den Anfang macht „It Doesn’t Have to Be Crazy at Work“ von den beiden Basecamp Gründern Jason Fried und David Heinemeier Hansson.

Im Buch stellen die Autoren in kurzen, schnell lesbaren Artikeln vor, wie Arbeit nicht sein sollte – und nebenbei lernt man, was für sie eine „Calm Company“ ist und warum das eigentlich gut ist.

Es geht um Termine, Meetingkultur, Deadlines, Arbeitsstunden, ständige Erreichbarkeit. Ich muss häufig schmunzeln, wenn ich ein Kapital aufschlage und Parallelen zur Konzernwelt entdecke.

Man lernt hier vor allem, wie man es nicht machen sollte – ganz klare Leseempfehlung daher von mir.

P.S.: Die Links haben einen Affiliate-Code und ich bekomm eine kleine Provision, falls jemand ein Buch darüber kauft.

Buchtipp: „It Doesn’t Have to Be Crazy at Work“

OneUptime: 2 Jahre nach AWS-Exit – $1,2 Millionen gespart

Das Observability-Startup OneUptime hat zwei Jahre nach seiner AWS-zu-Bare-Metal Migration eine ausführliche Bilanz gezogen und die härtesten Fragen aus Hacker News und Reddit beantwortet. Die ursprünglich prognostizierten $230.000 Einsparungen pro Jahr sind mittlerweile auf über $1,2 Millionen jährlich gewachsen.

Das Team beantwortet im Blog Artikel nun in einer Art FAQ die üblichen Fragen, die bei einer solchen Migration aufkommen:

Der MicroK8s + Ceph Stack läuft mit 99,993% Uptime – besser als AWS während der Region-Ausfälle. Die Customer-Latency sank um 19% dank lokaler NVMe-SSDs ohne Noisy Neighbours. Die Einsparungen flossen in Bare Metal AI-Server für LLM-basierte Features.

Zum Single Point of Failure: Zweites Rack in Frankfurt mit separatem Provider, asynchrone Ceph-Replikation, plus AWS-Failover-Cluster für Notfälle. Hardware-Lifecycle: 5-Jahre-Amortisation bei AMD EPYC 9654 mit 1TB RAM, Refresh alle 24 Monate möglich dank Kostenersparnis. Operational Toil: Nur 14 Engineer-Stunden pro Monat – vergleichbar mit vorherigen AWS-Optimierungsaufwänden.

Warum nicht alles mit Reserved Instances lösen? Selbst mit 90% Reservation Coverage bleiben S3, Egress (22% der Bill) und EKS-Fees ($1.260/Monat) teuer. Die Savings Plans decken diese nicht ab. Beim Bare-Metal-Setup spart OneUptime 76% verglichen mit optimiertem AWS.

Wann Cloud noch Sinn macht: OneUptime nutzt weiterhin Glacier, CloudFront und Burst-Kapazität für Tests. Die Empfehlung: Cloud bei spiky Workloads, Managed-Services-Abhängigkeit oder fehlendem Platform-Team. Bei steady-state Workload wie OneUptime jedoch rechnet sich Bare Metal klar.

Bei HackerNews wird wie gewohnt kontrovers diskutiert, was gibt’s da so?

Der Bare-Metal-Veteran (bilekas): „Wann haben die Leute vergessen, wie man einen Server betreibt?“ AWS ist extrem teuer und für die meisten Use Cases übertrieben – OneUptime erreichte 99,993% Uptime und entging dem AWS-Regionsausfall.

Der Lock-in-Kritiker (fulafel): Das Tückische ist das Team-Lock-in, nicht die Kosten. Man züchtet sich AWS-zertifizierte Teams heran, die nur noch „the AWS Way“ kennen statt selbst zu denken.

Der Self-Hosting-Skeptiker (Aurornis): Die Misserfolgsgeschichten werden nicht geteilt. Dutzende Startups verzetteln sich mit Self-Hosting in endlosen kleinen Tasks statt am Kernprodukt zu arbeiten – diese Stories werden nur nicht hochgevoted.

Ähnlich wie bei Basecamp’s 10-Millionen-Einsparung zeigt der Case: Der Cloud-Exit ist keine Ideologie, sondern pure Mathematik bei vorhersehbarer Last.

AWS to Bare Metal Two Years Later: Answering Your Toughest Questions About Leaving AWS

Zero-Downtime Infras Upgrades: Lessons from eBay und Snowflake

Kiran Bhat, Software Engineer mit langjähriger Erfahrung bei eBay und Snowflake, teilt in einem ausführlichen InfoQ-Artikel bewährte Strategien für Infrastructure-Upgrades ohne Ausfallzeiten. Seine Erkenntnisse basieren auf der Verwaltung von Systemen, die täglich Milliarden von Operationen über 50+ Regionen verarbeiten.

Die vier größten Herausforderungen:

Legacy-Systeme mit unbekannten Abhängigkeiten Original-Entwickler sind weg, Dokumentation fehlt, das System ist eine Black Box. Bhats Lösung: Systematische Discovery mit vier Kernfragen – Test-Coverage vorhanden? Monitoring aktiv? Debugging-Expertise im Team? Rollback möglich?

Performance-Risiken bei High-Volume-Systemen Kleine Degradationen haben massive Auswirkungen. Die Strategie: Baseline-Metriken erfassen, rigorose Stress-Tests durchführen, progressive Deployments nutzen (1% → 10% → 50% → 100%).

Rollback-Strategien kennen Nicht jede Änderung ist reversibel! Besonders bei Datenverschlüsselung, Schema-Changes oder Security-Updates. Irreversible Änderungen müssen vorab identifiziert und mit zusätzlicher Vorsicht behandelt werden.

Scope Creep vermeiden Bhats eiserne Regel: „Never add any additional improvements during upgrades – not even a single log line.“ Upgrades und Verbesserungen strikt trennen, sonst wird Debugging zum Albtraum.

Bhats 9-Punkte-Plan umfasst: Comprehensive Test-/Rollout-Plan, Investment in Test-Framework, frühe Stakeholder-Einbindung, klare Risikoanalyse, phased Rollouts, Rollback-Testing, messbare Success-Kriterien, 20-30% Zeitpuffer und definierte Post-Upgrade-Monitoring-Phase.

Die Parallelen zu den jüngsten AWS- und Azure-Ausfällen sind frappierend. Gerade die Warnung vor irreversiblen Changes und unzureichendem Testing scheinen bei den Hyperscalern selbst vernachlässigt worden zu sein. Auf der anderen Seite wissen wir auch alle, wie hart es ist, eine 100 % Produktionsgleiche Testumgebung hinzustellen. Auch hier ist der Artikel vo 18. August 2025 – also vor den beiden Ausfällen – mal schauen ob es bald ein Update dazu gibt.

Zero-Downtime Critical Cloud Infrastructure Upgrades at Scale

„Kafka ist schnell, nutze Postgres“: überraschender Benchmark

Ein ausführlicher Benchmark-Artikel auf TopicPartition stellt die provokante These auf: Postgres kann Kafka bei den meisten Workloads ersetzen – und liefert beeindruckende Zahlen.

Der Autor unterscheidet unterscheidet zwischen 2 Tech Lagern: dem Buzzword-Camp (resume-driven design, überengineerte Lösungen) und dem Common-Sense-Camp (pragmatisch, First Principles). Zwei Trends sprechen für Letzteres: Die Small-Data-Bewegung (128-Core-Maschinen mit 4TB RAM bei AWS) und die Postgres Renaissance mit dem Motto „Just Use Postgres“.

Pub-Sub Benchmarks: Ein 4-vCPU-Tri-Node-Setup (repliziert über 3 AZs) erreichte 5 MB/s Ingress und 25 MB/s Egress bei nur $11.514/Jahr – vergleichbare Kafka-Vendor-Lösungen kosten mindestens $50.000/Jahr. Das 96-vCPU-Setup schaffte sogar 238 MB/s Ingress und 1,16 GB/s Egress bei nur 10% CPU-Last.

Queue Benchmarks: Selbst bescheidene 4-vCPU-Nodes erreichten 2.885 msg/s mit Durability-Garantien. Der replizierte 3-Node-Cluster hielt 2.397 msg/s bei hoher Verfügbarkeit.

Selbst OpenAI nutzt unsharded Postgres trotz 800 Millionen Usern – warum braucht dein Startup dann Kafka? Die organisatorischen Kosten neuer Systeme (Monitoring, Runbooks, Expertise) überwiegen oft den technischen Benefit. Minimum Viable Infrastructure (MVI) statt premature Optimization.

Ähnlich wie bei Dagsters Entscheidung für Postgres als Message Queue: Boring Technology schlägt fancy Buzzwords. Und irgendwie sollten wir doch alle mehr auf Boring Technology stehen, oder nicht?

Kafka is fast — I’ll use Postgres

Nanit spart $500.000/Jahr – mit eigenem „S3“ in Rust

Das Babytech-Unternehmen Nanit hat in einem detaillierten Engineering-Post erklärt, wie sie durch eine selbstgebaute S3-Alternative massive Kosten einsparten. Das System verarbeitet tausende Video-Uploads pro Sekunde von Babykameras.

Das Problem: S3-Kosten explodierten

Nanits Video-Pipeline nutzte S3 als Landing-Zone für Kamera-Uploads. Bei Tausenden PutObject-Requests/Sekunde dominierten die Request-Gebühren die Kosten. Verschärft wurde das Problem durch S3-Lifecycle-Rules mit 1-Tag-Minimum – sie zahlten für 24 Stunden Storage bei Videos, die in ~2 Sekunden verarbeitet wurden.

Die Lösung: N3 – Rust-basierte In-Memory Landing-Zone

Nanit entwickelte N3, bestehend aus zwei Komponenten:

- N3-Proxy (stateless): Nimmt Uploads entgegen, macht auch TLS

- N3-Storage (stateful): Hält Videos im RAM für ~2 Sekunden

S3 dient nur noch als Overflow-Buffer bei Überlastung oder Ausfällen.

Technische Highlights

- Rust mit rustls: Native TLS-Terminierung statt Sidecar

- Graviton4-Optimierung: SVE2-Crypto-Features für +30% Performance

- DNS-Load-Balancing: Route53 statt teurem Network Load Balancer

- Delete-on-GET: Videos werden sofort nach Download gelöscht

- Graceful Restarts: Keine Datenverluste bei Updates

Das Team entdeckte durch Production-PoC und Stress-Tests kritische Bottlenecks: TLS-Terminierung fraß CPU, AWS-Burstable-Networking throttelte nach Credit-Verbrauch, und TCP-ACKs machten 85% des Egress-Traffics aus (gelöst durch Deaktivierung von TCP-Timestamps).

Build vs. Buy: Wann lohnt es sich?

Autor Miedwar Meshbesher betont: Custom Infrastructure lohnt sich nur bei ausreichender Skalierung UND spezifischen Constraints, die simple Lösungen ermöglichen. Bei Nanit waren das: ephemere Storage-Anforderungen, Loss-Toleranz der Algorithmen, und S3-Fallback als Sicherheitsnetz. Interessant, dass man dann überhaupt bei AWS geblieben ist….das wäre ja auch eine Chance gewesen, davon wegzukommen.

How We Saved $500,000 Per Year by Rolling Our Own “S3”

GizmoEdge meistert die 1 Trillion Row Challenge

Das GizmoData Team hat mit GizmoEdge ihre verteilte SQL-Engine am Coiled 1 Trillion Row Challenge getestet und beeindruckende Ergebnisse erzielt. Der Artikel vom 22. Oktober 2025 dokumentiert, wie ein 1.000-Worker-Cluster auf Azure die Billion-Zeilen-Herausforderung bewältigte.

Die Testumgebung bestand aus 63 Azure Standard E64pds v6 Nodes mit jeweils 64 vCPUs und 504 GiB RAM. Jeder Worker-Pod erhielt 3,8 vCPUs und 30 GiB RAM, was etwa 16 Worker pro Node ermöglichte – insgesamt also 4.000 CPUs und 30 TB Memory.

Performance-Ergebnisse

- Baseline Query (COUNT): unter 0,5 Sekunden für 1 Trillion Zeilen

- Aggregation Query (GROUP BY mit MIN/MAX/AVG): unter 5 Sekunden für 412 gruppierte Zeilen

- Jede Gruppe aggregierte etwa 2,4 Milliarden Zeilen

GizmoEdge nutzt DuckDB als Engine und verteilt Queries über TLS-verschlüsselte WebSockets. Die Daten werden auf lokalen NVMe SSDs gespeichert, mit SHA-256-Verifikation für Shard-Integrität.

Diskussion auf Hacker News

In der HN-Diskussion kam wichtige Kritik auf: Nutzer sdairs merkte an, dass die 5 Sekunden nur die Query-Zeit darstellen – das Laden der Daten von S3 dauerte zusätzlich über 2 Minuten. Für diese Performance müsste man 4.000 CPUs und 30TB RAM dauerhaft vorhalten – das macht dann natürlich nur in bestimmten Use-Cases Sinn.

Autor philbe77 stellte klar, dass die Daten auf NVMe SSD gespeichert wurden, nicht direkt im Memory, wobei otterley ergänzte, dass Linux-Caching trotzdem Memory-Effekte haben könnte.

Die Azure-Infrastruktur kostete $235,87/Stunde (On-Demand) bzw. $45,99/Stunde (Spot-Instanzen) – die 5-Sekunden-Query kostete theoretisch nur $0,33. Im Vergleich: Ein Snowflake 4XL Cluster kostet ungefähr $384/Stunde.

GizmoEdge Takes on the 1 Trillion Row Challenge

Nvidia investiert 1 Milliarde in Nokia & Telekom RZ – Bending Spoons übernimmt AOL

Zwei bemerkenswerte Übernahmen und Investitionen aus der Tech-Welt:

Nvidia sichert sich 5G/6G-Zukunft mit Nokia-Beteiligung

Nvidia investiert 1 Milliarde US-Dollar in Nokia und erhält dafür 2,9% Anteil am finnischen Unternehmen. Der Deal geht aber weit über eine reine Finanzinvestierung hinaus: Nokias kommende 5G- und 6G-RAN-Software wird auf Nvidia-Architektur laufen.

Die Kooperation zielt auch auf KI-Netzwerklösungen ab – ein direkter Angriff auf Unternehmen wie Arista Networks. Nvidia-CEO Jensen Huang sieht in KI-RAN die Revolution der Kommunikationsbranche. Der Hintergrund: Der Datenverkehr durch KI-Anwendungen explodiert, und beide Unternehmen wollen die Infrastruktur dafür gemeinsam aufbauen.

Interessant, wi NVIDIA nun überall mitmischt. Ich bin ja überzeugt, dass dies alles ohne 3dfx nie passiert wäre 😉

Hattest du mal eine Diamond Monster 3D? Vielleicht sogar die Version 2 im LSI Mode? Das waren noch Zeiten.

Deutsches AI-Rechenzentrum mit Deutsche Telekom

Parallel dazu baut Nvidia mit der Deutschen Telekom ein €1 Milliarden Rechenzentrum in München. Die Anlage wird rund 10.000 Nvidia GPUs beherbergen – deutlich kleiner als die 500.000 GPUs im geplanten Texas-Projekt von SoftBank/OpenAI/Oracle, aber ein wichtiges Signal für Europa. SAP ist bereits als Großkunde an Bord.

Das Projekt passt zur EU-Strategie: €200 Milliarden für AI-Kapazität in den nächsten 10 Jahren, Verdreifachung der Computing-Power in 7 Jahren. Huang hatte Europa wiederholt für langsamen Infrastruktur-Ausbau kritisiert – nun liefert Nvidia selbst die Antwort.

Bending Spoons kauft AOL für 2,8 Milliarden Dollar

Das italienische Software-Unternehmen Bending Spoons hat einen Vertrag zur Übernahme von AOL von Yahoo unterzeichnet. Die Transaktion soll noch vor Jahresende abgeschlossen werden.

AOL bringt immer noch beachtliche Nutzerzahlen mit: 8 Millionen täglich aktive und 30 Millionen monatlich aktive Nutzer – und gehört zu den Top-E-Mail-Anbietern weltweit. CEO Luca Ferrari sieht ungenutztes Potential und plant erhebliche Investitionen.

Für die Übernahme nahm Bending Spoons eine Fremdfinanzierung über 2,8 Milliarden Dollar auf. Das Portfolio des Unternehmens ist mittlerweile beeindruckend: WeTransfer, Evernote, Komoot, Vimeo, Filmics und Brightcove gehören bereits dazu. Bending Spoons betont, noch nie ein übernommenes Unternehmen weiterverkauft zu haben.

Bin ja immer wieder überrascht, wenn ich noch @aol.com E-Mail Adressen in Bounces oder bei Newsletter Subscribern sehe. Auch hier gibt es noch 2 Subsriber mit AOL Adressen – Hallo, warum bist du noch nicht umgestiegen?

Bending Spoons sehe ich eher skeptisch – zumindest bei Komoot scheint das nicht unbedingt zu einem besseren Produkt zu führen – auf der anderen Seite habe ich das auch „kostenlos“ genutzt, bis auf den Einmal Kauf einer Karte – davon kann man natürlich App-seitig auch nicht leben.

Nvidia investiert 1 Mrd. US-Dollar in Nokia

Schmunzelecke

Bei vibe-coded.lol findest du eine nette Website, die komplett Vibe-Coded ist, damit spielt die Website dann auch, überall, sogar in den Cookies. Ganz witzig, aber jetzt nicht der Knaller, ich weiß.

und bei Instagram gibt es ein lustiges Video zu „Friday Deployments“.

💡 Link Tipps aus der Open Source Welt

BrowserOS – Open-Source Agentic Browser

BrowserOS ist ein Open-Source Chromium-Fork, der KI-Agenten nativ im Browser ausführt. Das Projekt positioniert sich als privacy-first Alternative zu ChatGPT Atlas, Perplexity Comet und Dia, mit dem Ziel, Browsing durch lokale AI-Automation zu revolutionieren.

Features:

- Native KI-Agenten: Beschreibe Tasks in natürlicher Sprache – der Browser führt Klicks, Eingaben und Navigation automatisch aus

- Split-View AI: ChatGPT, Claude, Gemini oder lokale Modelle in der Seitenleiste auf jeder Website

- MCP Server Support: Vorinstallierte Server für Gmail, Calendar, Docs, Sheets und Notion

- Privacy-First: Eigene API-Keys oder lokale Modelle via Ollama/LMStudio

- Chrome-Kompatibilität: Gleiche Oberfläche wie Chrome, funktioniert mit allen Extensions

- Semantic Search: Durchsuche History und Bookmarks nach Bedeutung, nicht nur Keywords

- Built-in Highlighter: Wichtige Informationen direkt auf Webseiten markieren und speichern

Plattformen: macOS, Windows, Linux (AppImage & Debian)

Das Projekt wird aus San Francisco entwickelt und hat bereits über 6.7k GitHub Stars. Die Vision: Browser sollten Open Source und privacy-first sein, nicht Tracking-Software für Werbeunternehmen. Mehr Infos findest du auf der Website – hast du sowas schon genutzt?

https://github.com/browseros-ai/BrowserOS

Twake Drive – Open-Source Alternative zu Google Drive

Twake Drive ist eine verschlüsselte Open-Source Datenspeicherlösung, entwickelt von LINAGORA. Das Projekt positioniert sich als privacy-first Alternative zu Google Drive mit Fokus auf Datensouveränität und On-Premise-Deployment.

Features:

- Ende-zu-Ende-Verschlüsselung: Jede Datei und ihre Metadaten werden mit eigenem Schlüssel verschlüsselt

- Shared Drives: Zentrale Team-Arbeitsbereiche für kollaborative Projekte

- OnlyOffice Integration: Integrierte Office-Suite für Dokumente, Tabellen und Präsentationen

- Erweiterte Suche: Volltext-Suche nach Inhalt, Name oder Absender

- Rechteverwaltung: Granulare Zugriffsrechte und sichere Link-Freigaben

- Single Sign-On: Ein Account für alle Twake Workplace Produkte (Drive, Chat, Mail)

- API-First: HTTPS APIs für nahtlose Integration

- Self-Hosting: Vollständige Kontrolle durch Installation auf eigener Infrastruktur

Tech-Stack: TypeScript/JavaScript Frontend, Node.js Backend mit MongoDB oder PostgreSQL Support. Docker-basiertes Deployment mit minimal Setup-Option.

Die Software steht unter AGPL-3.0 Lizenz und ist Teil des Twake Workplace Ökosystems zusammen mit Twake Chat und Twake Mail.

https://github.com/linagora/twake-drive

❓ Feedback & Newsletter Abo

Vielen Dank, dass du es bis hierhin geschafft hast!

Kommentiere gerne oder schicke mir Inhalte, die du passend findest.

Falls dir die Inhalte gefallen haben, kannst du mir gerne auf Twitter folgen.

Gerne kannst du mir ein Bier ausgeben oder mal auf meiner Wunschliste vorbeischauen – Danke!

Möchtest du den Newsletter wöchentlich per E-Mail erhalten?

Einfach hier abonnieren: